Unterstützung von Arbeitskräften mittels Mixed Reality

Dieses Projekt hat zum Ziel, ein Wizard-Interface auf der Grundlage von Mixed Reality zu entwickeln. Es soll Arbeitskräften ermöglichen, eine Aufgabe auszuführen und das notwendige Gefühl der Kontrolle über die Maschine zu erlangen.

Steckbrief

-

Beteiligte Departemente

Hochschule der Künste Bern

Technik und Informatik - Institut(e) Institute for Human Centered Engineering (HuCE)

-

Forschungseinheit(en)

HuCE / Labor für Computerwahrnehmung und virtuelle Realität

Knowledge Visualization - Strategisches Themenfeld Themenfeld Humane Digitale Transformation

- Förderorganisation BFH

- Laufzeit (geplant) 01.10.2022 - 31.12.2022

- Projektleitung Prof. Dr. Sarah Dégallier Rochat

-

Projektmitarbeitende

Michael Flückiger

Mitra Gholami - Schlüsselwörter Human-Machine Interface, Mixed Reality, neue Fähigkeiten

Ausgangslage

Um der wachsenden Vielseitigkeit des Marktes gerecht zu werden, müssen die Produktionsmittel flexibler werden. Es braucht neuartige Systeme, sogenannte AMS (Anthropocentric Manufacturing Systems – menschzentrierte Fertigungssysteme), bei denen die Arbeitskraft die Kontrolle hat. Das Ziel ist, die Effizienz der Automatisierung zu nutzen und gleichzeitig die Flexibilität der menschlichen Arbeit zu bewahren. Anstelle eines speziell für eine bestimmte Aufgabenstellung konzipierten Systems sollen flexible Robotersysteme entwickelt werden, die auch von Nichtfachleuten leicht an neue Aufgaben und Arbeitsbereiche angepasst werden können. Es werden also Tools benötigt, die sowohl die Interaktion mit der Maschine vereinfachen als auch der Arbeitskraft helfen, die Funktionsweise des Systems besser zu verstehen.

Vorgehen

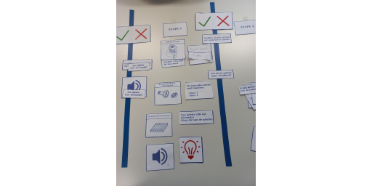

Unser Ziel in diesem Projekt ist es, ein Wizard-Interface auf der Grundlage von Mixed Reality zu entwickeln, das es Arbeitskräften nicht nur ermöglicht, eine Aufgabe auszuführen, sondern auch das notwendige Gefühl der Kontrolle über die Maschine zu erlangen. Dafür wurde ein nutzerzentrierter Ansatz gewählt. Es wurden zwei Workshops mit zehn Mitarbeitenden des Unternehmens Bien-Air SA organisiert. Ziel des ersten Workshops war es, Antworten zu den beiden folgenden Fragen zu erhalten: (a) Wie viel will/muss der User über das System wissen, um es nutzen zu können? (b) Welche Modalitäten würden die Interaktion für die Bedienenden intuitiver/angenehmer machen? Die Bedienenden wurden gebeten, mithilfe von Karten mit verschiedenen Arten von Informationen ihr ideales Interface zu designen. Dabei konnten die Bedienenden auch eigene Karten definieren. Auf der Grundlage der Ergebnisse des ersten Workshops wurde dann ein Low-Fidelity-Prototyp entworfen. Dieser wurde im zweiten Workshop mittels Thinking-Aloud-Verfahren getestet und mit einem herkömmlichen, textbasierten Interface verglichen. Anschliessend wurden beide Interfaces anhand des User Experience Questionnaire (UEQ) und der System Usability Scale (SUS) bewertet. Zudem wurden kurze Interviews mit den Bedienenden durchgeführt und für die Analyse transkribiert.

Ergebnisse

Die Ergebnisse des ersten Workshops deuten darauf hin, dass die Bedienenden vorzugsweise mit einer Kombination aus Bildern und Texten arbeiten. Die Bilder sind wichtig, da einige der Bedienenden nicht französischer Muttersprache sind. Der Text ist besonders am Anfang wichtig, wenn die User noch nicht mit dem Interface vertraut sind. Wenn die User das System einmal kennen, sollte der Text ausgeblendet werden können. Es wurde ein Low-Fidelity-Interface auf der Grundlage von Mixed Reality entwickelt. Dabei wurde eine schematische Darstellung des Arbeitsbereichs mit den Bildern der Kameras kombiniert. Über die Bilder wurde ein Overlay gelegt, um dem User die Sicht des Roboters anzuzeigen (zum Beispiel um zu erkennen, welche Teile korrekt von ihm erkannt und lokalisiert wurden). Ein zweiter Prototyp wurde auf der Grundlage eines herkömmlichen, textbasierten Assistenten entwickelt. Im zweiten Workshop testeten die Bedienenden mit einem A/B-Testprotokoll beide Interfaces in zufälliger Reihenfolge. Beide Interfaces wurden mittels UEQ und SUS bewertet. Dabei ergab sich eine leichte Präferenz für das Interface, das auf Mixed Reality beruht. Dies spiegelte sich in den Interviews wider, in denen die Bedienenden mehr Begeisterung für das neue Interface zeigten.

Ausblick

In den kommenden Monaten wird ein High-Fidelity-Prototyp entwickelt und von denselben Bedienenden getestet, dieses Mal mit dem echten Roboter. Das Interface wird auf der Grundlage des Feedbacks der Bedienenden verbessert und fliesst in die Erstellung der Längsschnittstudie im Rahmen des SNF-Projekts «Cobotics, digital skills and the re-humanization of the workspace» und des Innosuisse-Projekts «Kollaboratives Roboter-System für grosse Produktevielfalt bei kleinen Losgrössen» ein.